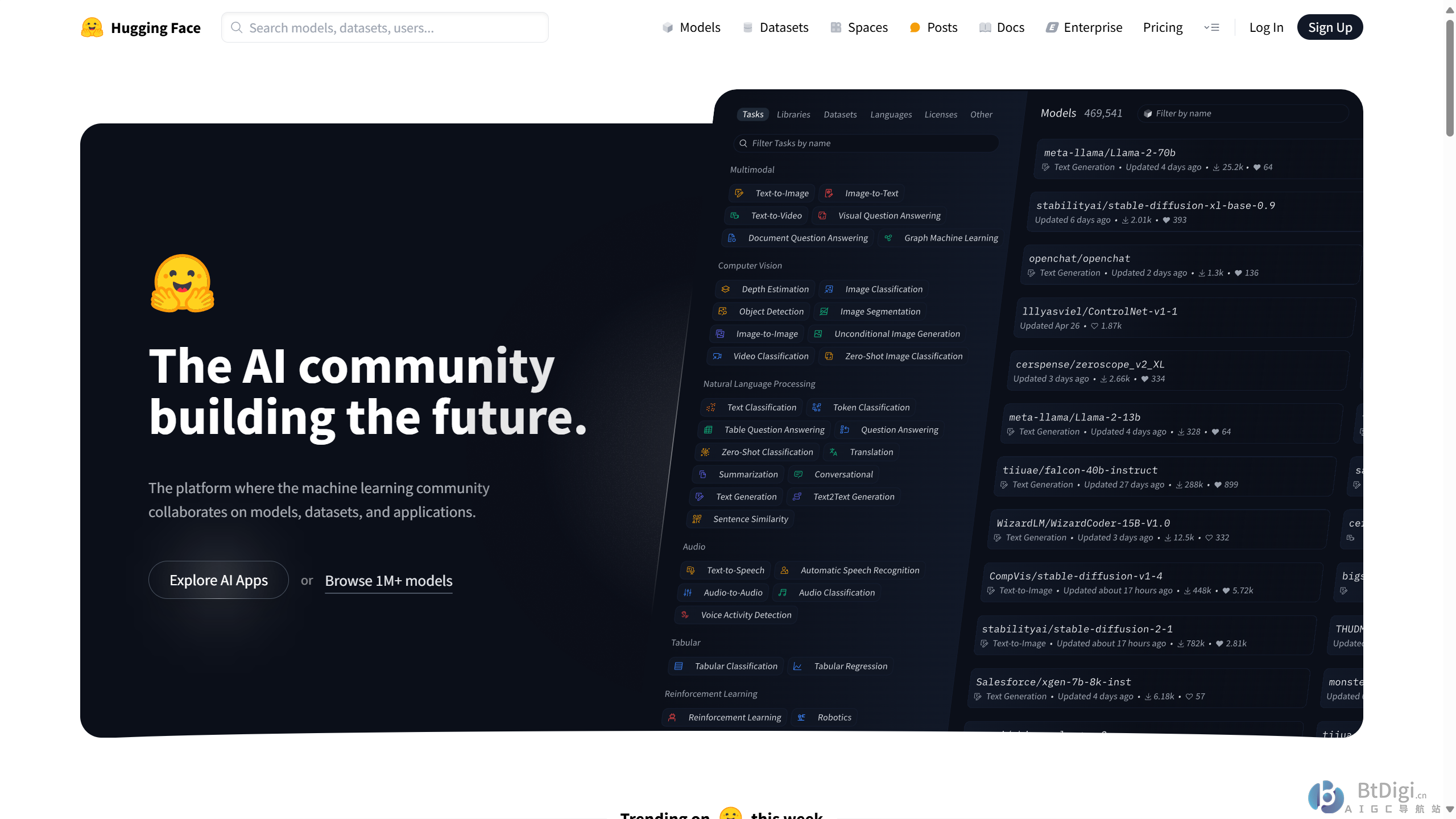

一、平台与社区

Hugging Face平台旨在推动NLP技术的平民化,让开发者能够轻松使用最先进的NLP技术。它拥有庞大的开发者社区,用户可以分享模型、数据集和工具,共同推动NLP技术的发展。社区中的成员包括来自Meta、Google、Microsoft、Amazon等在内的超过5000家组织机构,他们为Hugging Face开源社区贡献代码、数据集和模型。

二、核心功能与资源

- Transformers库:Hugging Face以其Transformers Python库而闻名,该库提供了大量预训练的NLP模型,如BERT、GPT、RoBERTa等,支持文本分类、文本生成、问答系统等多种任务。这些预训练模型可以大大缩短开发者的研发周期,提高开发效率。

- Datasets库:Hugging Face还提供了Datasets库,简化了数据集的下载、预处理和加载过程。它支持多种公开数据集,如SQuAD、IMDB等,使得开发者可以更加方便地获取和处理数据。

- Tokenizer:用于文本分词和预处理,支持多种语言和模型。这有助于开发者将输入文本转换为模型可处理的标记(tokens),支持清洗、截断和填充等操作。

- 模型微调:开发者可以使用Hugging Face提供的预训练模型进行微调,以适应特定任务。微调过程相对简单,只需要使用少量标注数据对预训练模型进行训练即可。

三、使用场景与优势

Hugging Face的工具适用于多种NLP任务,包括但不限于文本分类(如情感分析、垃圾邮件检测)、文本生成(如对话生成、故事续写)、问答系统、机器翻译等。其优势主要体现在以下几个方面:

- 可访问性:Hugging Face提供了预训练模型、微调脚本和用于部署的应用程序接口,使得创建LLM(大型语言模型)的过程变得更容易。即使是没有深厚技术背景的开发者也能快速上手。

- 集成性:Hugging Face的Transformers库可与PyTorch和TensorFlow等其他ML框架集成,方便开发者选择适合自己的框架进行开发。

- 经济高效:使用Hugging Face的托管模型可以节省资金和时间,因为开发者无需从头开始构建大型ML模型。此外,Hugging Face还提供了经济高效、可扩展的解决方案,满足企业的需求。

四、挑战与考虑因素

- 偏差:与任何预训练的机器学习模型一样,Hugging Face上提供的模型容易受到偏见的影响。这可能会导致模型生成性别歧视、种族主义或仇视同性恋的内容。因此,在使用这些模型时需要进行充分的测试和验证。

- 计算要求:对于一些较大的模型,如Bloom等,可能需要比平台默认提供的计算量更多的资源。这可能会增加运行成本和时间。

- 安全性:使用Hugging Face的企业应确保平台提供的安全措施符合企业的数据安全需求。在上传和下载模型时需要注意数据保护和安全性问题。

综上所述,Hugging Face是一个功能强大且易于使用的NLP平台,提供了丰富的预训练模型、工具和资源。无论是初学者还是有经验的开发者都可以通过Hugging Face快速构建和部署NLP应用。然而,在使用时也需要注意上述挑战和因素以确保开发过程的顺利进行。